Hexo-优化seo

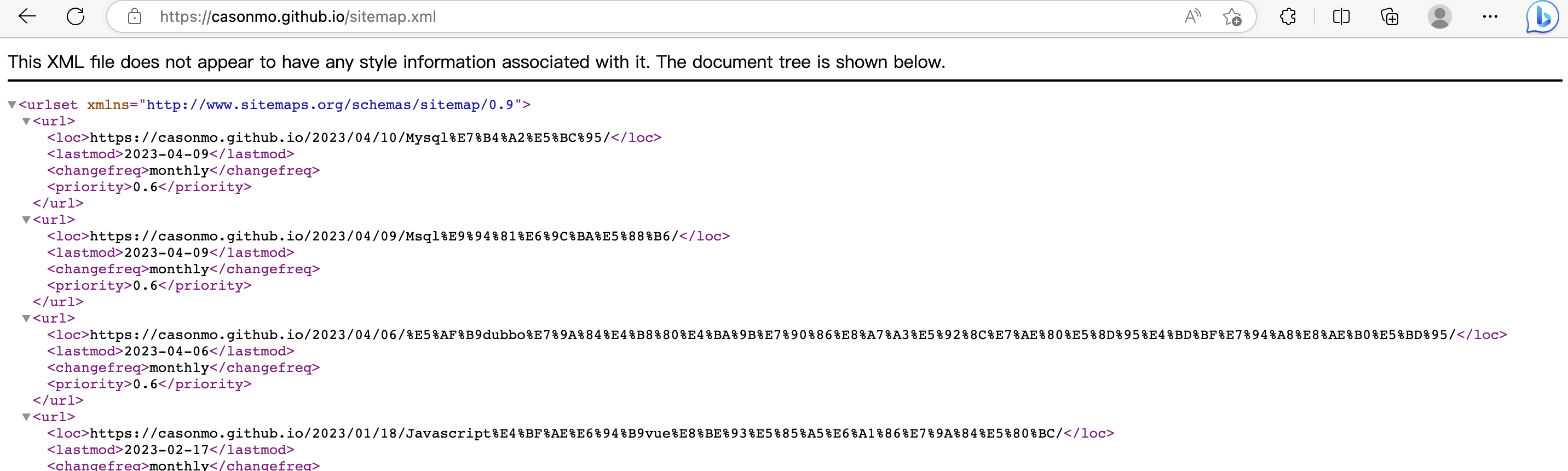

Sitemap

Sitemap是一种包含网站所有页面URL的XML文件,有助于搜索引擎更快地索引和发现您的网站。以下是在Hexo中使用Sitemap优化SEO的步骤:

- 安装hexo-generator-sitemap插件。可以使用以下命令进行安装:

1 | |

- 在Hexo配置文件_config.yml中添加以下内容:

1 | |

其中,path是Sitemap文件的生成路径;exclude是要排除的页面列表;lastmod用于在Sitemap中包含最后修改时间;priority表示页面的重要性,值的范围为0.0到1.0;changefreq表示页面更新频率。

- 生成Sitemap。使用以下命令在Hexo中生成Sitemap文件:

1 | |

这将生成Sitemap文件并将其部署到您的网站目录下。

- 提交Sitemap到搜索引擎。将Sitemap文件提交到Google Search Console和Bing Webmaster Tools等搜索引擎工具中,以帮助搜索引擎更快地发现和索引您的网站。

通过使用Sitemap,您可以确保搜索引擎可以找到您的网站的所有页面,并更好地理解您网站的结构和内容,从而提高您的网站在搜索结果中的排名。

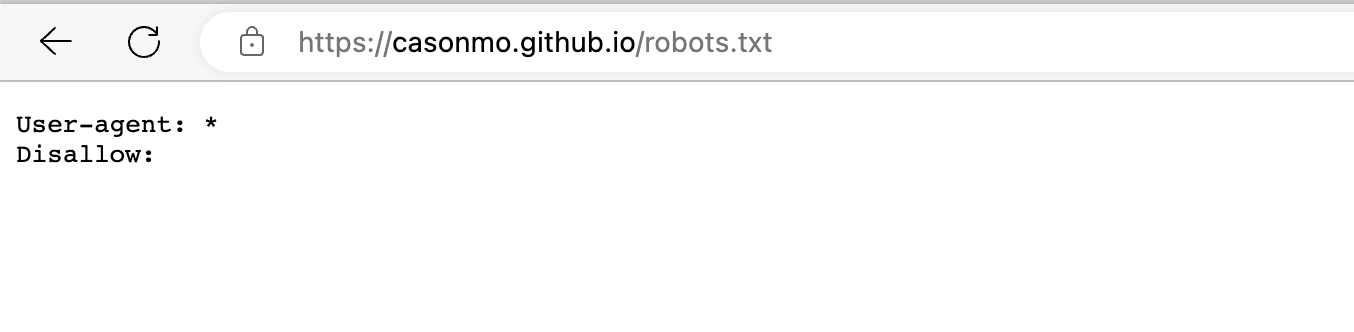

Robots.txt

Robots 文件是一个文本文件,用于向搜索引擎指示哪些页面可以访问和索引,哪些页面应该被忽略。通过优化 Robots 文件,可以提高您的网站在搜索引擎中的排名和曝光度。

在 Hexo 中使用 Robots 文件进行 SEO 优化,可以按照以下步骤操作:

- 在 Hexo 根目录下创建一个名为

robots.txt的文件。 - 打开

robots.txt文件,输入以下内容:

1 | |

其中,User-agent: * 表示允许所有搜索引擎访问您的网站,Disallow: 表示允许搜索引擎访问您的网站中所有页面和文件。

- 如果您需要禁止某些搜索引擎访问您的网站,请添加以下内容:

1 | |

其中,[搜索引擎名称] 表示您要禁止访问的搜索引擎名称,Disallow: / 表示禁止该搜索引擎访问您的网站中所有页面和文件。

例如,如果您想禁止 Google 访问您的网站,可以将以下内容添加到 robots.txt 文件中:

1 | |

- 保存并上传

robots.txt文件到您的网站根目录下。 - 使用 Google Search Console 的 Robots.txt 检查工具,检查您的 Robots 文件是否存在问题,并且是否被正确解析。

注意:Robots 文件可以帮助您优化 SEO,但是也需要谨慎使用。请确保您了解 Robots 文件的规则和用法,以避免出现意外的问题。

Hexo-优化seo

https://cason.work/2023/04/10/Hexo-优化seo/